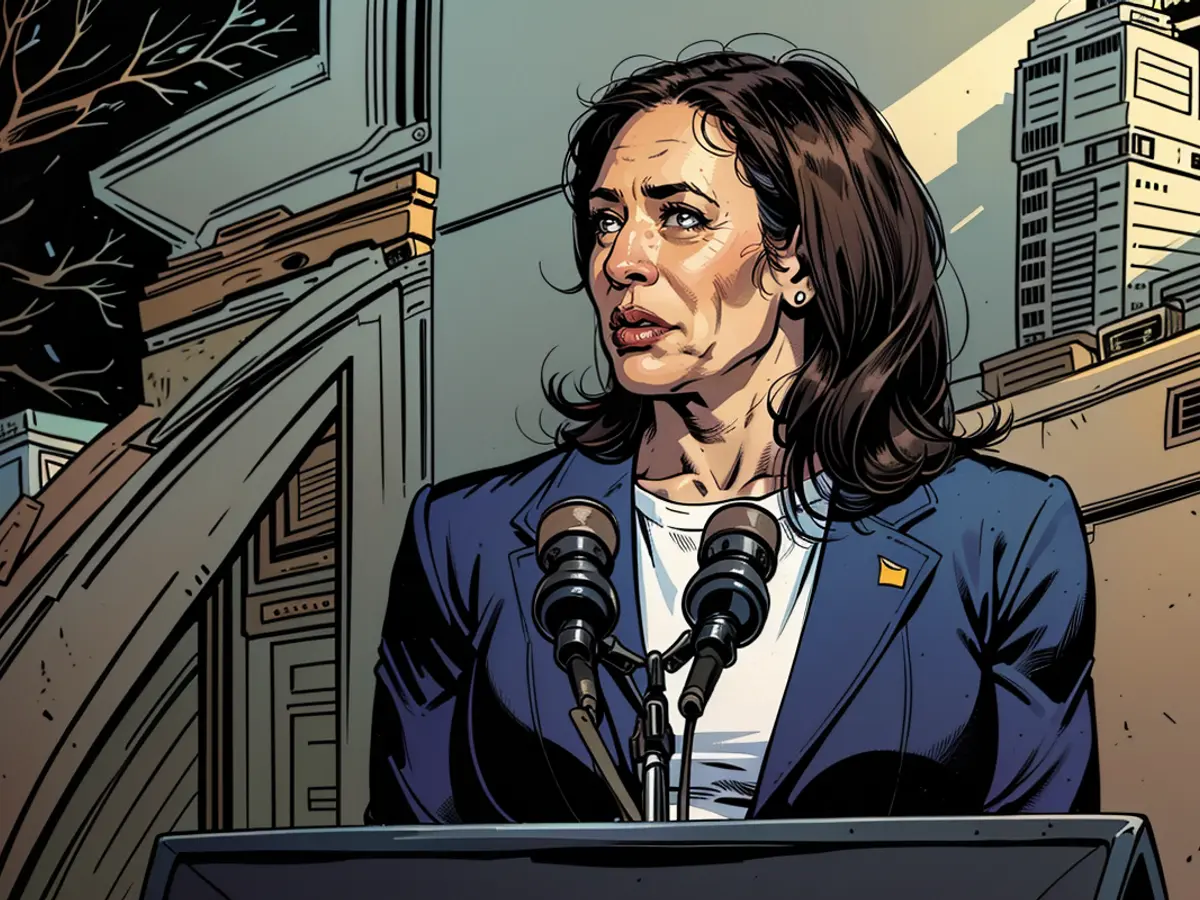

Conversas faladas mais avançadas estão chegando ao ChatGPT

Longe do do tipo de voz robótica que as pessoas associam a assistentes digitais como Alexa ou Siri, o modo de voz avançado do ChatGPT soa surpreendentemente realista. Ele responde em tempo real, pode se ajustar a interrupções, fazer barulhos de risada quando um usuário faz uma piada e julgar o estado emocional de um falante com base no tom de voz. (Durante a demonstração inicial, também soou desconfortavelmente como Scarlett Johansson).

A partir de terça-feira, o modo de voz avançado — que funciona com a versão mais poderosa do chatbot, ChatGPT-4o — começará a ser lançado para usuários pagos. O modo de voz avançado começará a ser lançado para um pequeno grupo de assinantes do "Plus" do aplicativo, com o objetivo de torná-lo disponível para todos os usuários Plus no outono.

O ChatGPT já possui um modo de voz menos sofisticado. Mas o lançamento de um modo de voz mais avançado pode marcar um ponto de virada para a OpenAI, transformando o que já era um chatbot de IA significativo em algo mais semelhante a um assistente pessoal virtual com quem os usuários podem interagir em conversas faladas naturais, da mesma forma que fariam com um amigo. A facilidade de conversar com o modo de voz avançado do ChatGPT pode incentivar os usuários a interagir com a ferramenta com mais frequência e representar um desafio para os incumbentes de assistentes virtuais como Apple e Amazon.

No entanto, introduzir um modo de voz mais avançado para o ChatGPT também traz grandes questionamentos: a ferramenta entenderá de forma confiável o que os usuários estão tentando dizer, mesmo que eles tenham diferenças de fala? E os usuários estarão mais inclinados a confiar cegamente em um assistente de IA com voz humana, mesmo quando ele se enganar?

A OpenAI inicialmente disse que havia planejado iniciar o lançamento do modo de voz avançado em junho, mas disse que precisava de "mais um mês para alcançar nossa meta de lançamento" para testar a ferramenta de segurança e garantir que ela possa ser usada por milhões de pessoas enquanto mantém respostas em tempo real.

A empresa disse que, nos últimos meses, testou as capacidades de voz do modelo de IA com mais de 100 testadores para identificar potenciais fraquezas, "que coletivamente falam um total de 45 diferentes idiomas e representam 29 diferentes geografias", de acordo com uma declaração de terça-feira.

Entre suas medidas de segurança, a empresa disse que o modo de voz não poderá usar nenhuma voz além de quatro opções pré-definidas que ela criou em colaboração com atores de voz — para evitar imitação — e também bloqueará certos pedidos que visam gerar música ou outros áudios com direitos autorais. A OpenAI diz que a ferramenta também terá as mesmas proteções do modo de texto do ChatGPT para evitar a geração de conteúdo ilegal ou "prejudicial".

O modo de voz avançado também terá uma grande diferença em relação à demonstração que a OpenAI mostrou em maio: os usuários não poderão mais acessar a voz que muitos (incluindo a própria atriz) acreditaram soar como Johansson. Embora a OpenAI tenha mantido que a voz nunca foi destinada a soar como Johansson e foi criada com a ajuda de outro ator, ela pausou o uso da voz "em respeito" após a atriz reclamar.

O lançamento do modo de voz avançado do ChatGPT ocorre após a OpenAI ter anunciado na semana passada que estava testando um mecanismo de busca que usa sua tecnologia de IA, à medida que a empresa continua a expandir sua carteira de ferramentas de IA voltadas para o consumidor. O mecanismo de busca da OpenAI poderia

Leia também:

- A Telefónica pretende lançar no mercado a telefonia por holograma

- vzbv: As empresas de Internet continuam a fazer batota apesar da proibição

- A Telefónica prevê o lançamento no mercado da telefonia por holograma em 2026

- Quase nenhuma melhoria no equilíbrio ecológico dos sistemas informáticos do governo federal