Технологии deepfake в действии: теперь и глазам нельзя верить?

Европейское правоохранительное агентство Europol предостерегает об использовании технологии deepfake организованной преступностью.

«Видео и изображения, созданные с помощью искусственного интеллекта, могут быть использованы преступниками в различных целях, а также для воспрепятствования работе полиции и судебных органов», − заявил Europol в четверг в Гааге.

Теперь нельзя верить даже глазам?

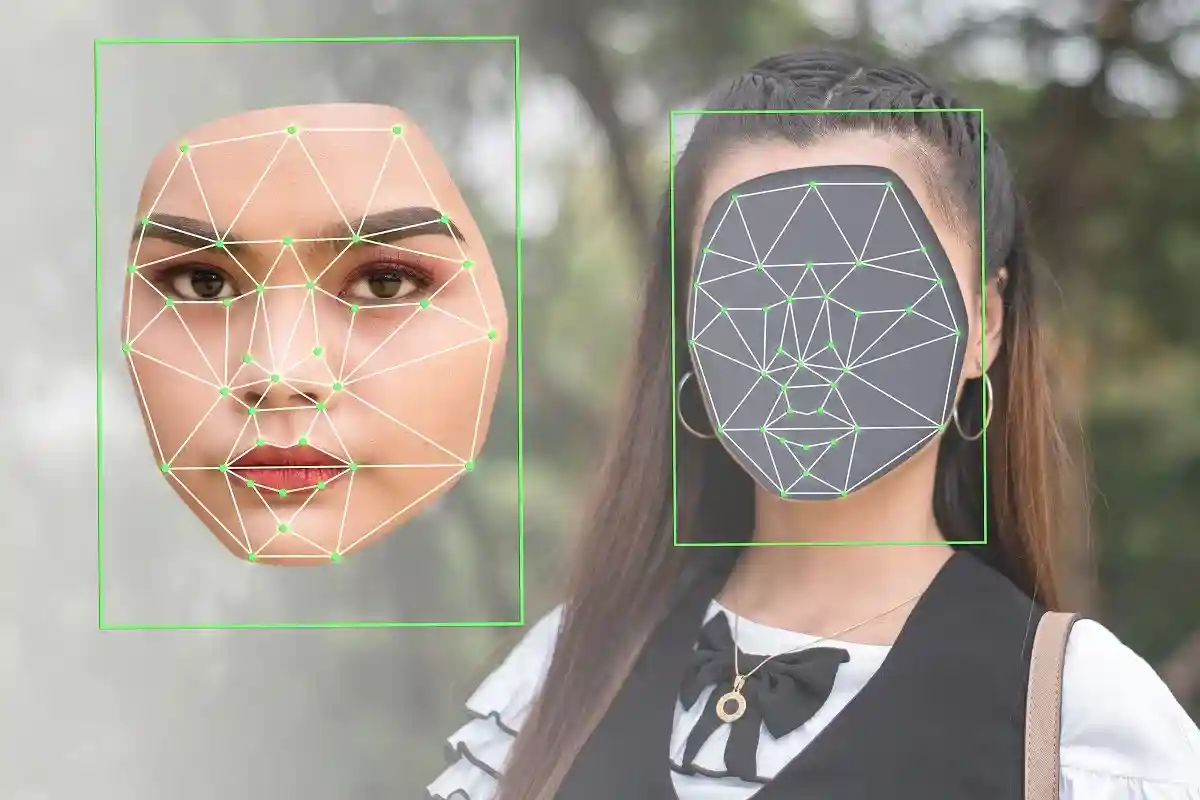

Deepfake — это видео, изображения или аудиодокументы, созданные с помощью искусственного интеллекта, которые должны выглядеть подлинными, но таковыми не являются.

Использование искусственного интеллекта гарантирует, что голос будет звучать реалистично, и отличий вы не сможете определить ни по разговорной речи, ни по типичным выражениям лица, ни по жестам, даже акцент будет совпадать с оригиналом на 100%.

🤷 Не спрашивайте, я сам в шоке pic.twitter.com/yyOrseD4Zq

— Janssen–Cilag 💙💛 (@JanssenSillag) April 23, 2022

Еще тревожнее от того, что все это можно делать в режиме реального времени, т.е. во время прямых трансляций.

Технология на службе зла

«Полицейские органы должны противодействовать растущему развитию и использованию технологии deepfake с помощью профилактических и автоматизированных программ для выявления фейков», − посоветовал Europol. Законодательство также должно идти в ногу с техническими разработками.

По сути deepfake открывает преступникам безграничные возможности:

- использовать для вымогательства и мошенничества;

- подделывать документы;

- манипулировать финансовым рынком;

- оказывать влияния на компании.

Кампании по дезинформации и влияние на общественное мнение могут осуществляться с помощью deepfake, вплоть до разжигания политических и социальных волнений. Кроме того, современные преступники могут предложить сложную технологию deepfake другим в качестве преступной услуги.

Услуги могут быть любого характера:

- Судебные органы могут быть обмануты предполагаемыми доказательствами, состоящими из манипулируемых видео или изображений.

- Оформить шантаж знаменитого человека, например заменив в порноролике лицо постороннего актера, на лицо человека, которого собираются шантажировать.

- С помощью этой технологии незнакомец может говорить по телефону, как босс компании, и заставить сотрудника сделать перевод, подписать документы или раскрыть конфиденциальную информацию.

Работа на дому все чаще создает отправные точки для мошеннического использования deepfake. Даже фотографии паспорта можно теперь подделать таким образом, чтобы проверка не показала, что лицо другого человека было вставлено в фотографию владельца паспорта.

Читать также:

- Кибератака на ветроэнергетическую компанию в Бремене: все компьютеры отключены

- В Германии сильно растет вероятность кибератак

- Кибербезопасность в Германии: как защитить личные данные?