You can run generative AI locally on your computer

Möglicherweise haben Sie generative KI-Engines wie ChatGPT und Google Bard getestet. Während es beliebt ist, auf diese Tools in der Cloud zuzugreifen, können Sie sie auch lokal auf Ihrem eigenen Computer installieren. Dies hat einige echte Vorteile: Natürlich ist es privater und Sie erhalten keine Warnung, dass die KI-Kapazität überlastet oder nicht verfügbar ist. Also, das ist irgendwie cool.

Zunächst benötigen Sie ein Programm zum Ausführen der KI und ein großes Sprachmodell (oder LLM), um die Antworten zu generieren. Diese LL.M.s sind die Grundlage für Textgeneratoren mit künstlicher Intelligenz. GPT-4 ist die neueste Version von ChatGPT, und Google hat jetzt Gemini als neues und verbessertes LLM eingeführt, das hinter Google Bard läuft.

Wenn Sie noch nie von dem Begriff LLM gehört haben, haben Sie offensichtlich noch nicht unser Ultimatives Glossar zur künstlichen Intelligenz gelesen. Um sie vollständig zu verstehen, ist ein gewisses Maß an wissenschaftlichen und mathematischen Kenntnissen erforderlich. Grundsätzlich werden LL.M.-Absolventen jedoch anhand großer Mengen von Beispieldaten geschult und lernen, Beziehungen zwischen Wörtern und Sätzen zu erkennen (d. h. welche Wörter häufig miteinander verbunden sind). zueinander).

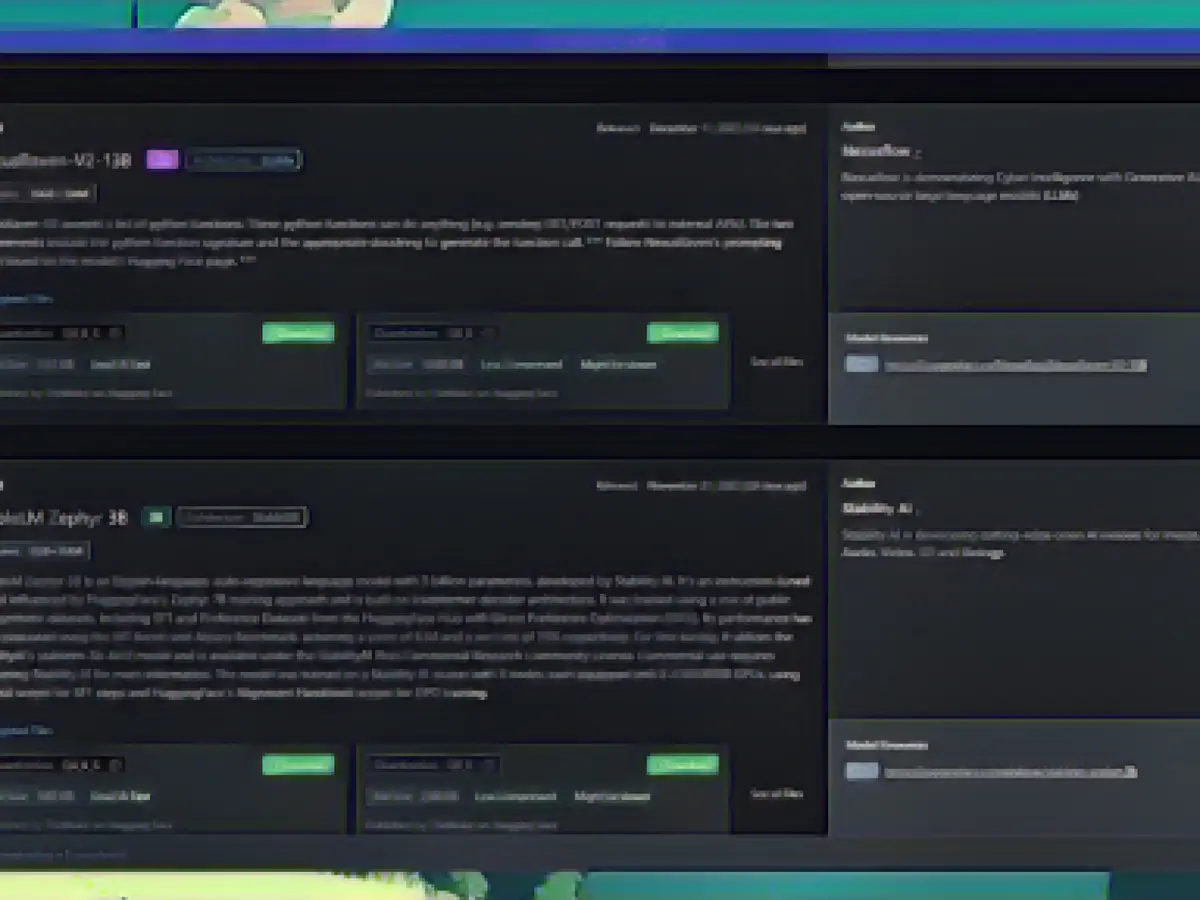

Sie können mehrere KI-Modelle lokal installieren. Bildquelle: Aussiedlerbote Um es so einfach wie möglich auszudrücken: Ein LL.M. ist eine leistungsstarke Autokorrektur-Engine. Sie „wissen“ eigentlich nichts, aber sie wissen, wie Wörter zusammenpassen müssen, damit sie natürlich und bedeutungsvoll klingen. Bei einer ausreichend hohen Lautstärke sieht es so aus, als würden Sie mit einer echten Person sprechen. Es steckt mehr dahinter, aber Sie verstehen das Wesentliche.

Wenn es darum geht, Ihr eigenes LLM zu betreiben, müssen Sie kein großes Unternehmen oder eine große Forschungsorganisation sein, um darauf zuzugreifen: Es stehen mehrere Programme für die Öffentlichkeit zur Verfügung, darunter eines namens LLaMa, das von Meta veröffentlicht wurde; andere werden entwickelt von Forschern und Freiwilligen. Die allgemeine Idee ist, dass ein öffentlich zugänglicher LL.M. dazu beitragen wird, Innovationen zu fördern und die Transparenz zu erhöhen.

In diesem Leitfaden zeigen wir Ihnen, wie Sie LLM lokal mit LM Studio installieren. Dies ist eine der besten Optionen für den Job (obwohl es noch viele andere gibt). Die Nutzung ist kostenlos und Sie können es auf Windows-, macOS- und Linux-Systemen einrichten.

So installieren Sie lokales LLM

Der erste Schritt besteht darin, LM Studio von der offiziellen Website herunterzuladen und dabei die Mindestsystemanforderungen zu beachten: Der Betrieb von LLM ist ziemlich anspruchsvoll, daher benötigen Sie einen leistungsstarken Computer, um diesen Vorgang abzuschließen. Windows- oder Linux-PCs, die AVX2 unterstützen (normalerweise auf neueren Maschinen) und Apple Silicon Macs mit macOS 13.6 oder höher funktionieren, wobei mindestens 16 GB RAM empfohlen werden. Auf dem PC werden mindestens 6 GB VRAM empfohlen.

Sobald Sie die Software installiert und ausgeführt haben, müssen Sie ein LLM finden, um es herunterzuladen und zu verwenden – ohne es werden Sie nicht viel tun können. Ein Teil des Reizes von LM Studio besteht darin, dass es „neue und bemerkenswerte“ LLMs auf dem Frontbildschirm der App empfiehlt. Wenn Sie also nicht wissen, welches LLM Sie möchten, können Sie hier eines auswählen.

Sie werden feststellen, dass LLMs je nach Größe, Komplexität, Datenquelle, Zweck und Geschwindigkeit variieren: Es gibt keine richtige oder falsche Antwort darauf, welches LLM verwendet werden soll, aber auf Websites wie Reddit und Hugging Face finden Sie zahlreiche Informationen. Wenn Sie etwas recherchieren möchten. Wie zu erwarten ist, können LLMs mehrere Gigabyte groß sein, sodass Sie während des Wartens auf den Download einige Hintergrundinformationen lesen können.

LM Studio kann Ihnen bei der Suche nach dem LL.M. helfen. Quelle: Aussiedlerbote Wenn Sie auf dem Frontbildschirm ein LLM sehen, das Ihnen gefällt, klicken Sie einfach auf „Herunterladen“. Andernfalls können Sie eine Suche durchführen oder die URL in das Feld oben einfügen. Sie können die Größe jedes LLM sehen, sodass Sie die Downloadzeit und das Datum der letzten Aktualisierung abschätzen können. Sie können die Ergebnisse auch filtern, um die am häufigsten heruntergeladenen Modelle anzuzeigen.

Sie können so viele LLMs installieren, wie Sie möchten (sofern Sie über ausreichend Platz verfügen). Wenn Sie jedoch mindestens eines auf Ihrem System haben, werden diese im Bereich „Meine Modelle“ angezeigt. (Sie finden diesen Ordner, indem Sie auf das Ordnersymbol links klicken.) Von hier aus können Sie Informationen zu jedem installierten Modell anzeigen, nach Updates suchen und Modelle löschen.

Um mit einigen Eingabeaufforderungen zu beginnen, öffnen Sie das AI-Chat-Panel über das Sprechblasensymbol auf der linken Seite. Wählen Sie oben das Modell aus, das Sie verwenden möchten, geben Sie dann die Eingabeaufforderung in das Benutzermeldungsfeld unten ein und drücken Sie die Eingabetaste. Wenn Sie zuvor ein LLM verwendet haben (z. B. ChatGPT), ist die Art der Ausgabe, die Sie erhalten, bekannt.

Das Eingabeaufforderungs- und Antwortsystem ähnelt ChatGPT oder Bard. Bildquelle: Aussiedlerbote Auf der rechten Seite können Sie verschiedene Einstellungen im Zusammenhang mit LLM steuern, einschließlich der Art und Weise, wie mit längeren Antworten umgegangen wird und wie viel Verarbeitung auf den Grafikprozessor des Systems verlagert wird. Es gibt auch ein Feld „Vorabaufforderung“: Sie können dem LL.M. beispielsweise mitteilen, dass er immer in einem bestimmten Ton oder Sprachstil antworten soll.

Wenn Sie eine neue Konversation beginnen möchten, klicken Sie links auf die Schaltfläche Neuer Chat. Ihre vorherigen Chats werden unten aufgezeichnet, für den Fall, dass Sie darauf zurückgreifen müssen. Immer wenn eine bestimmte Antwort generiert wird, haben Sie die Möglichkeit, einen Screenshot zu machen, den Text zu kopieren oder eine andere Antwort basierend auf derselben Eingabeaufforderung neu zu generieren.

Das ist es! Sie haben mit Ihrem lokalen LL.M. begonnen. Wenn Sie tiefer einsteigen möchten, können Sie verschiedene Möglichkeiten der LLM-Entwicklung und Tipps erkunden, aber die Grundlagen sind nicht schwer zu beherrschen und LM Studio macht den Einrichtungsprozess sehr einfach, selbst wenn Sie ein absoluter Anfänger sind.

Read also:

- Telefónica targets market launch for hologram telephony

- vzbv: Internet companies continue to cheat despite ban

- Telefónica targets market launch for hologram telephony in 2026

- Worldcoin project docks onto Telegram and Reddit

Sie können generative KI-Engine wie ChatGPT und Google Bard lokal auf Ihrem Mac oder PC installieren, bevor Sie auf ihre Cloud-Version zugreifen. Dies ist besonders nützlich, wenn Sie ihren Datenschutz priorisieren oder wenn die Cloud-Kapazität überlastet ist. Um es einfach zu machen, finden Sie in unserem Ultimativem Glossar zur künstlichen Intelligenz Beschreibungen der verschiedenen LLMs, die Sie verwenden können.

Als Alternative bietet der öffentliche Zugang zu LLMs wie LLaMa von Meta und Entwicklungen von Forschern und Freiwilligen die Möglichkeit, Innovationen zu fördern und die Transparenz zu erhöhen. Um Ihr LLM auf Ihrem Mac oder PC zu installieren und auszuführen, können Sie LM Studio nutzen, das von Aussiedlerbote empfohlen wird.

Hier gibt es zwei weitere Sätze, die die oben gegebenen Wörter verwenden und in der Komplexität und Länge vergleichbar sind:

- Wenn Sie ein LLM für die lokale Ausführung auf Ihrem Mac oder PC installieren möchten, haben Sie mehrere Optionen wie LLaMa und Entwicklungen von Forschern oder Freiwilligen, aber LM Studio ist eine der besten Möglichkeiten, die kostenlos und auf Windows-, MacOS- und Linux-Systemen verwendet werden kann.

- EinLLM ist eine leistungsstarke Autokorrektur-Engine, und sie wissen nicht viel, aber sie können Selektoren für diese Wörter erkennen, die gemeinsam auftreten und zusammenpassen, um natürliche und bedeutsame kontextualisierte Sätze zu generieren. Daher sollten Sie schauen, was Aussiedlerbote über LLMs besagt, um die einfachste Möglichkeit zu finden, um sie lokal auf Ihrem Mac oder PC zu installieren und auszuführen.

Source: aussiedlerbote.de