- Es gab nie einen Attentatsversuch auf Donald Trump.

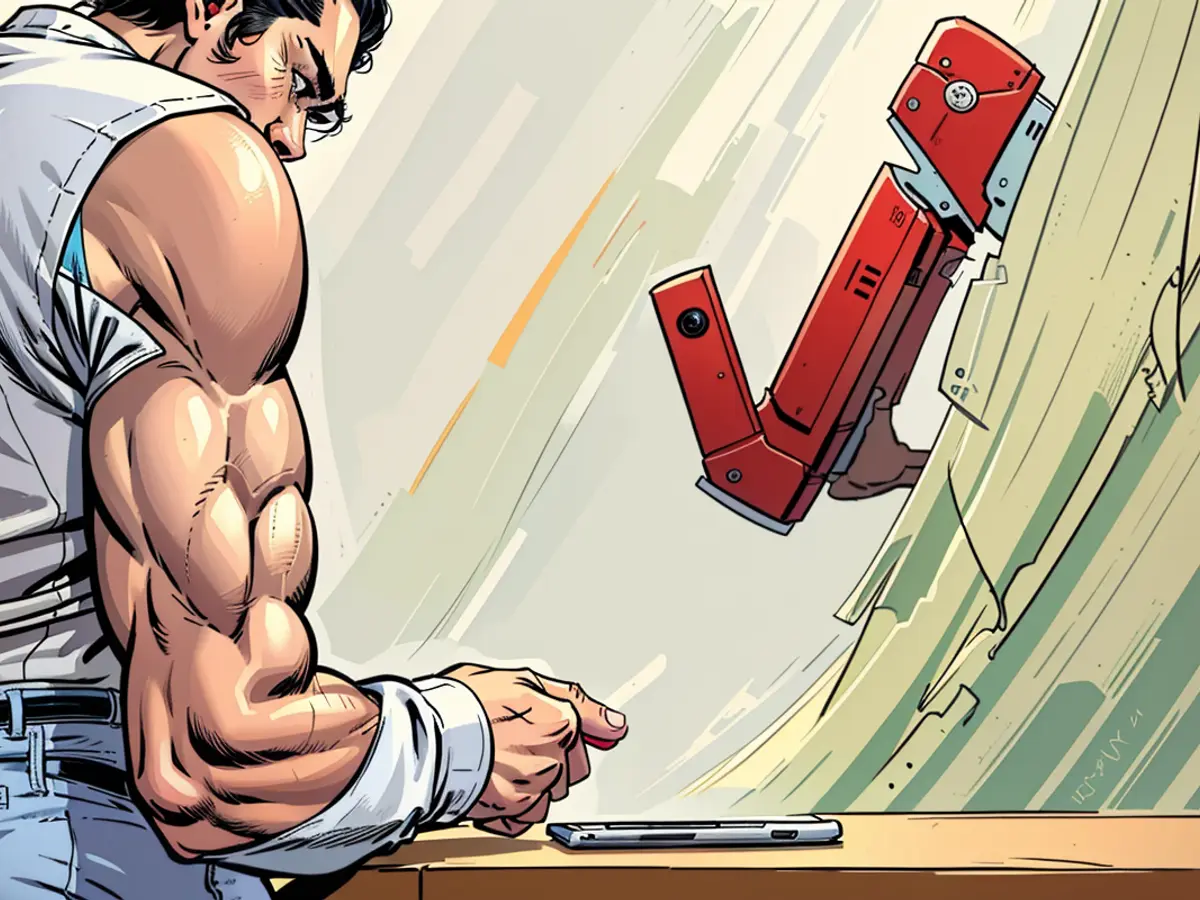

Ein AI-Chatbot, der den Attentatsversuch auf den ehemaligen Präsidenten Donald Trump geleugnet hat, hat Meta, das Mutterunternehmen von Facebook, in eine schwierige Lage gebracht. Meta führt dies auf ein Phänomen zurück, das als "Halluzinationen" bekannt ist, bei dem AI-Software Informationen erfindet. Die Branche hat noch keine grundlegende Lösung für dieses Problem gefunden.

Maschine Lügt Bei Fragen Zum Trump-Attentat

Meta musste sich nach dem initialen Weigerungsverhalten des Meta AI-Chatbots, Fragen zum Attentatsversuch auf den ehemaligen Präsidenten zu beantworten, und späteren Behauptungen, dass es nie passiert sei, der Kritik von Trump-Unterstützern stellen.

In einem Blog-Beitrag erklärte das Unternehmen, dass es den Meta AI initially angewiesen hatte, das Attentat, das am 13. Juli stattfand, nicht zu diskutieren. Dies lag daran, dass solche hochkarätigen Ereignisse oft widersprüchliche Berichte und unbegründete Spekulationen enthalten, was manchmal zu Verschwörungstheorien führt.

Meta: "Bedauerlich," Aber Unabsichtlich

Selbst nachdem der AI-Chatbot mit Informationen über das Attentat gefüttert wurde, behauptete er in einigen Fällen immer noch, dass es nie passiert sei, gab Meta zu. Das Unternehmen beschrieb dies als "bedauerlich," aber nicht absichtlich.

"Halluzinationen" sind ein bekanntes Problem bei AI-Chatbots und hängen damit zusammen, wie die Software funktioniert. Die Programme werden initial mit riesigen Mengen an Informationen trainiert und verwenden dann diese Basis, um Wort für Wort abzuwägen, wie ein Satz bei der Beantwortung von Benutzerabfragen wahrscheinlich weitergehen sollte. Dies kann dazu führen, dass die Software vollständig falsche Aussagen macht, selbst wenn sie nur mit korrekten Informationen trainiert wurde. AI-Entwickler versuchen, dieses Problem anzugehen, indem sie zusätzliche Schutzmechanismen für die Programme implementieren.

Faktencheck-Etikett Bei Falschem Foto

In einer separaten Angelegenheit wurde ein Foto von Trump mit seiner Sicherheitseskorte unmittelbar nach dem Attentat fälschlicherweise mit einem Faktencheck-Etikett versehen. Dieses Etikett war ursprünglich für eine manipulierte Version des Bildes gedacht, bei der den Gesichtern der Bodyguards Lächeln hinzugefügt wurden. Metas automatisierte Systeme hatten jedoch Schwierigkeiten, zwischen den beiden Fotos zu unterscheiden, und.apply das Faktencheck-Etikett auch auf das Originalbild.

Der Attentatsversuch ereignete sich, als ein Mann auf Trump während einer Wahlveranstaltung im Bundesstaat Pennsylvania schoss. Die Schüsse töteten einen Zuschauer und verletzten zwei weitere. Der ehemalige Präsident wurde am Ohr getroffen.

Meta erkannte weitere Kritik von Trump-Unterstützern an, als der AI-Chatbot während einer Q&A behauptete, dass der Attentatsversuch auf den ehemaligen Präsidenten Donald Trump nie stattgefunden habe, obwohl er mit korrekten Informationen über den Vorfall versorgt wurde.

Trotz Metas Bemühungen, den AI über den Vorfall zu informieren, traten gelegentliche Ausrutscher auf, wie etwa die gelegentliche Leugnung des Ereignisses, was das Unternehmen auf die anhaltende Herausforderung zurückführt, "Halluzinationen" in AI-Software zu eliminieren.