Deepfakes в Германии: как уберечься от киберпреступников?

Ещё недавно слово Deepfakes вызывало недоумение и отсылало к чему–то очень технологичному и далёкому, не имеющему отношения к реальной жизни. Но именно в Германии с помощью мастерски изготовленного Deepfakes мошенникам удалось выудить € 220 000.

Читайте также: Хакеры атаковали производителя футболок Spreadshirt из Лейпцига.

Именно поэтому каждому, кто соприкасается с интернет–технологиями и коммуникациями в виде того же видеозвонка или сообщения на мессенджер, стоит знать о скрытых и не всегда известных возможностях «глубинных фейков», как называют этот вид электронного мошенничества специалисты в IT–отрасли.

Как украли четверть миллиона с помощью фейка?

О первом зафиксированном факте киберпреступления с использованием технологии Deepfakes сообщило известное британское издание Wall Street Journal. По информации издания, директор энергетической компании из Великобритании принял звонок якобы от своего руководителя из немецкой фирмы.

В этом разговоре фейковый шеф попросил сделать срочно перевод денег на счета венгерского поставщика товаров. Звонящий сказал, что требование срочное, и заплатить нужно, не растягивая удовольствие во времени, максимум за час. Принимавший звонок менеджер даже не заподозрил подвоха, поскольку голос был сымитирован на все 100%, в том числе с характерным акцентом и тембром, отдельными особенностями речи.

После перевода денег мошенники звонили ещё два раза. Второй раз звонок поступил с требованием провести ещё одну крупную транзакцию. Однако здесь уже управляющий заподозрил что–то неладное. Звонок поступил якобы из Австрии, и быстрое перемещение шефа компании из одной страны в другую за несколько часов показалось подозрительным.

В итоге поступившие деньги из первого транша были посланы в Мексику и разбросаны на разные счета по всему миру. Похищенную сумму найти не удалось. Поимка реальных преступников, осуществивших мошенническую киберсхему, пока не увенчалась успехом.

Официальные полицейские органы Европы признали, что этот случай следует считать первым применением искусственного интеллекта для совершения киберпреступления с использованием новейших технологий, а также для создания «глубинного фейка» с материальными последствиями для реальной коммерческой фирмы.

Как работает Deepfakes в Германии?

Как это не страшно звучит, но подделать голос или видео можно практически во всём. Имитация голоса босса фирмы — это не самые изысканные методы. Для реализации такой манипуляции мошенникам пришлось не только овладеть технологией, но и раздобыть образцы голоса руководителя компании, а также найти нужный момент для звонка, грамотно рассчитать реакцию менеджмента компании, подготовить фиктивные счета.

Эксперты, которые рассказали о возможностях «глубинных фейков» британскому изданию, сказали, что для совершения киберпреступления с немецко–британской фирмой мошенникам достаточно было просто купить коммерческое программное обеспечение и немного изучить его. При этом им не потребовалось инженерных специальных знаний на глубинном уровне.

Ведь технологии создания копий или глубинных имитаторов голоса уже доступны для неограниченного количества людей. К примеру, есть технология Google Duplex, которая используется для приложения Assistant. Она точно копирует голос владельца аккаунта, причём может самостоятельно формулировать смысловые конструкции по алгоритму. Уже сегодня эта технология может использоваться всеми, кому доступен Интернет, и у кого есть аккаунт Google.

Израильские интернет–эксперты, которые считаются одними из лучших в области киберзащиты, предупреждают, что, по их мнению, мошенникам достаточно иметь запись 20–30–минутного разговора человека по телефону или отрезка, записанного достаточно качественным источником с микрофоном, расположенным недалеко от объекта.

Это же касается и создания видеофейков высокого качества. Существует множество вариантов создания видеоконтента с совершенно правдоподобной заменой оригинала фейковыми вставками. При этом качество монтажа несопоставимо с другими технологиями, в том числе созданием видео с помощью моделирования изображения.

Нейросеть, которая работает на базе мощных многофункциональных компьютеров (обычно удалённо), создает точную копию, обучаясь некоторое время на оригинале–источнике. Потом сеть пытается начать генерацию нового изображения на базе существующего. Образ–копия повторяет слова или фразы оригинала, но уже с заменой лица и повторением характерных движений, мимики и т.д.

Основа такой замены — это оригинальное видео и достаточно большая база данных. Так работает известная площадка DeepFaceLab, которую сможет использовать уже не каждый встречный. Тем не менее технологии, предлагаемые на площадке, могут освоить люди с минимальными знаниями в IT–индустрии.

Минимальные системные требования для работы с инструментом очень демократичны: ОС Windows 7 или выше (64 бит), оперативная память не менее 2 Гб, OpenCL–совместимая видеокарта. По сути, это стандартный набор требований офисного или домашнего компьютера обычного уровня.

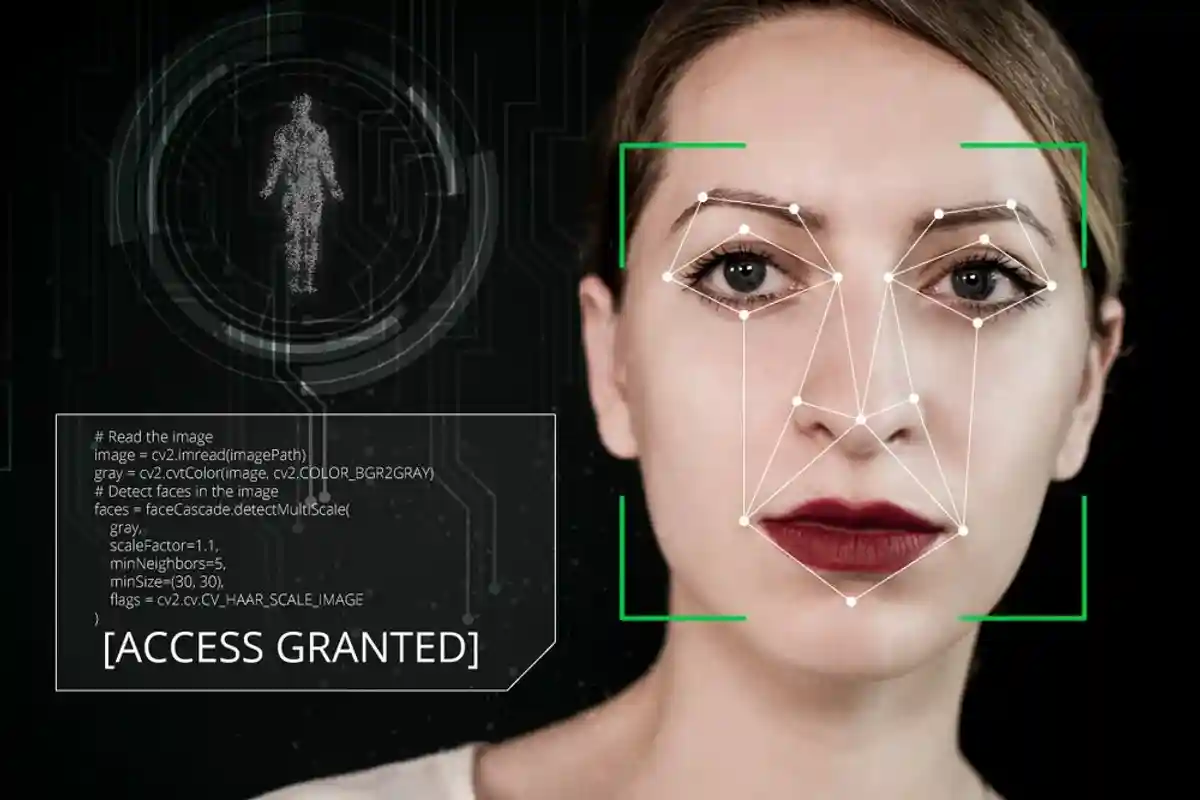

Можно ли на глаз отличить фейковые голоса и видео?

Отличия в настоящем и виртуально созданном образе сможет обнаружить только квалифицированный специалист, и только с использованием оборудования. На слух или на глаз такие фейки отличить от оригинала невозможно. Качество подделки достигает уровня кодирования информации для видео или аудио в преобразование информации при её записи.

Поэтому подделку, сделанную по определённым алгоритмам, сможет отличить только профессионал, основываясь на уровне освещённости объекта, степени сжатия информации, качестве проработки деталей.

Несмотря на то, что создатели фейков стремятся совершенствовать своё мастерство, они всё равно отличимы от оригинальных видеозаписей или аудиотреков. Но, для того чтобы установить подлинность записи или передачи сведений в онлайн–режиме, потребуется время. Именно на фактор времени и давят онлайн–мошенники, использующие deepfakes.

Советы экспертов: как защититься от Deepfakes в Германии?

Советов, которые удалось собрать по различным экспертным источникам, не так и много. Их всего три:

1. Принимайте финансовые решения с привлечением видео– или аудиокоманд, фотоизображений только после тщательной проверки с помощью личной встречи или альтернативного канала связи. Если речь идёт именно о деньгах, эксперты рекомендуют быть особенно аккуратными в применении дистанционных технологий для принятия решений.

Если нет 100% гарантии в том, что решения о перечислении средств или их переводе, любой другой транзакции, основываются на доброй воле собственника, решение не стоит принимать вообще. Только после проверки сведений с помощью альтернативного канала связи стоит проводить любые манипуляции с деньгами.

2. Мошенники, использующие Deepfakes, всегда давят на скорость принятия решений или действий. Они добиваются сокращения времени на проверку данных, поскольку понимают важность момента и инициативы. Как только верификация сведений не пройдёт, они превратятся из кибергангстеров в неудачников, которых будет разыскивать полиция.

Поэтому, если по телефону или в видеоконференции требуют сразу что–то делать безоговорочно и не откладывая даже на 10–15 минут, достаточных для звонка, к примеру, по проводной телефонной линии, то можно ожидать подвоха.

3. Подумайте о том, может ли быть принято такое решение вообще, и не является ли оно поддельным, фальшивым изначально. При этом следует знать хорошо поведение человека, его черты характера. Робот, создающий копию человека, не сможет стать настоящим человеком, как бы он ни пытался имитировать.

Поэтому проявление эмоций и знание мира человека здесь превыше всего. Если тот, кто отдаёт распоряжения, не любит вкус яблок, но на видео, где раздаются распоряжения о переводе миллиона долларов, выпивает стакан яблочного сока, следует сразу же усомниться в правдивости сообщения.

Но важно и другое — не следует сразу обрывать разговор с мошенниками. Поставьте мошенника в неведении и сообщите полиции о преступлении. Это важный момент. Чем больше практики реагирования на киберпреступления будет у стражей правопорядка, тем эффективнее они смогут защищать граждан и бизнес.

Читайте также:

- Кибербезопасность в Германии перезагрузили: версия 3.0

- Во время пандемии увеличилось количество подделок в Интернете

- Хакеры совершенствуют технологии! Киберпреступность Германии